Inteligencia Artificial ahora se utiliza para estafar y crear malware en la DeepWeb

Estas herramientas son usadas por ciberdelincuentes.

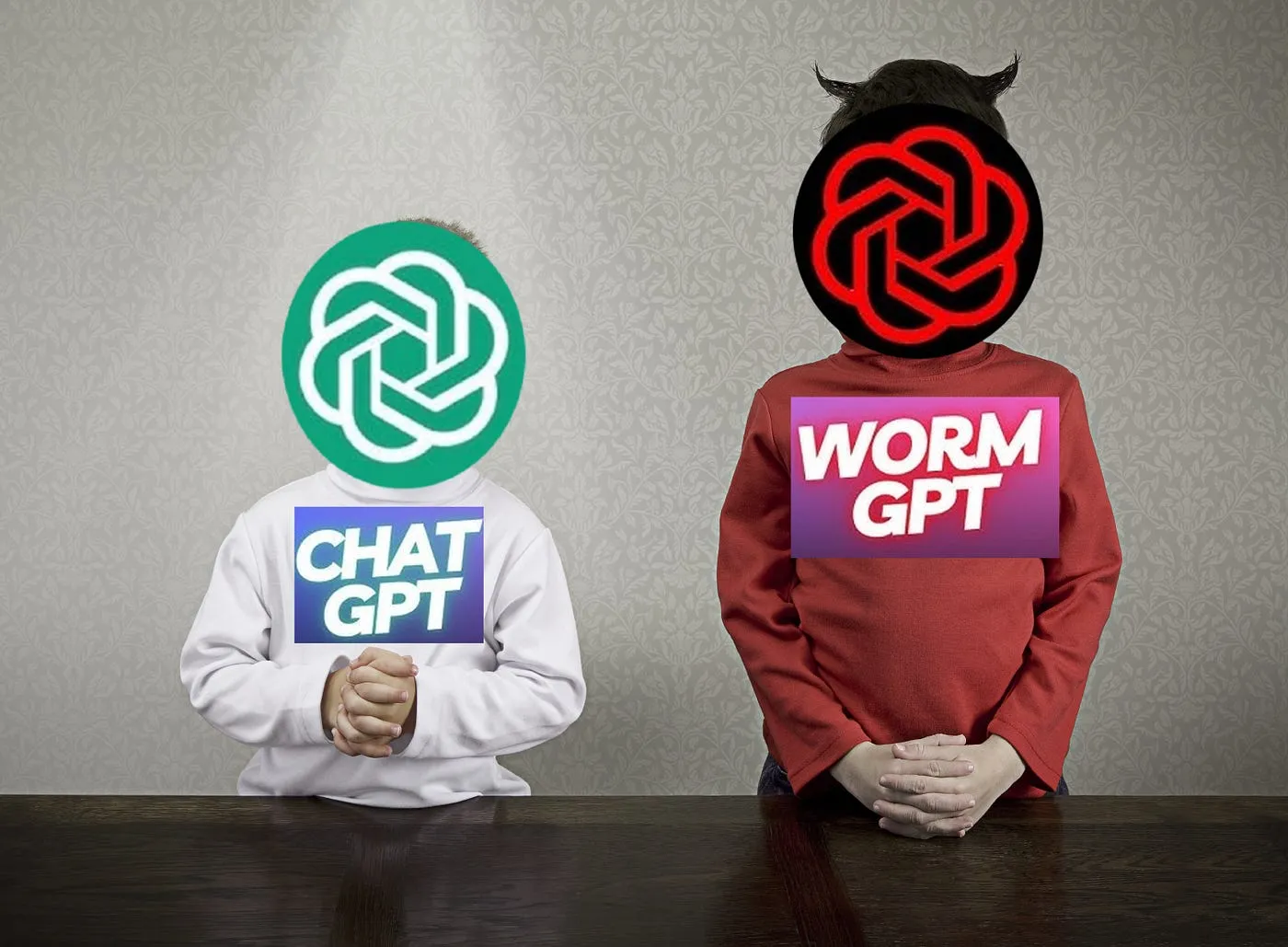

Los delincuentes cibernéticos presumen actualmente de emplear las amplias capacidades de la inteligencia artificial generativa para desarrollar modelos con habilidades equiparables a las de ChatGPT y Bard de Google.

Inteligencia Artificial “malévola”

Estos modelos especializados se orientan hacia actividades ilícitas, tales como la suplantación de identidad bancaria o la creación de sitios web propensos a fraudes.

FraudGPT y WormGPT representan algunos de los nuevos sistemas maliciosos que están surgiendo en la Deep Web.

Según la plataforma de análisis de datos Netenrich, estos sistemas posibilitan la creación de correos electrónicos fraudulentos y la ejecución de ataques de phishing altamente persuasivos.

Mucho más caros que ChatGPT

Además, ofrecen la capacidad potencial de generar deepfakes y llevar a cabo campañas de desinformación de manera efectiva.

El primer chatbot, considerado por algunos como el “gemelo malévolo de ChatGPT”, no está exento de costos. Este servicio no es gratuito y ninguna de sus funciones lo es. Ofrece dos planes distintos: uno mensual por $100 dólares y otro privado con un costo de $500 dólares.

La introducción de estas herramientas marca un cambio significativo en el panorama de la cibercriminalidad, evidenciando un perfeccionamiento y una segmentación cada vez mayores en su uso. Los expertos advierten sobre el potencial desarrollo de malware más sofisticado, impulsado por la inteligencia artificial generativa.

Estafas mediante Inteligencia Artificial

Esta tecnología facilita a los atacantes la generación de correos maliciosos en diversos idiomas, eliminando los errores típicos que solían delatarlos en el pasado. Este avance representa un desafío adicional para los sistemas de detección.

Para los expertos en ciberseguridad, estas herramientas delictivas plantean un serio problema de cara al futuro.

Permiten que incluso aquellos delincuentes con conocimientos técnicos limitados puedan orquestar campañas maliciosas de todo tipo, con una probabilidad de éxito considerable.

Abordando esta problemática con información

La educación y la concienciación de los usuarios se destacan como elementos cruciales para prevenir los riesgos asociados con estas herramientas maliciosas. No obstante, se reconoce la necesidad de complementar estos esfuerzos con medidas regulatorias y soluciones tecnológicas.

En respuesta a los peligros emergentes, se propone la creación de equipos independientes encargados de evaluar herramientas de este tipo en busca de posibles abusos de la inteligencia artificial, y se plantea la posibilidad de prohibir ciertos modelos de código abierto.

No obstante, el desafío para mitigar los daños causados por FraudGPT y herramientas similares radica en lograr un equilibrio entre los imperativos éticos de la inteligencia artificial y la implementación práctica de medidas de seguridad y regulación.